Полный аудит сайта

Автор: Леонид Гроховский

Настоящий документ представляет собой описание SEO аудита. Аудит включает более 700 проверок. При проведении аудита используется более 50-ти программ, плагинов и сервисов. Проверки выполняются по 25 группам факторов. Ориентировочное время на проведение аудита – 120-200 часов, но может варьироваться в зависимости от размеров проекта. В таком виде аудит изучают слушатели полного курса SEO специализаций продвижение каталога, продвижение интернет-магазинов и продвижение порталов. По такому формату проводится полный аудит в ТопЭксперт.

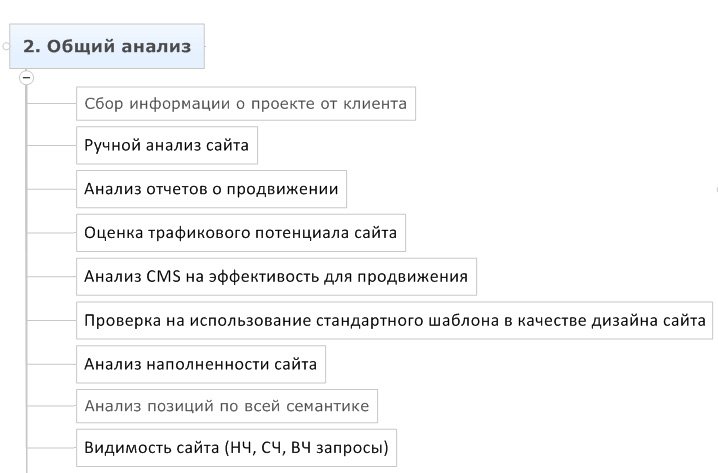

Часть #1 - Общий анализ сайта

1.1 Сбор информации о проекте от клиента

Для того, чтобы работа велась эффективно, необходимо изучить историю проекта и текущее состояние. Чем больше данных предоставит клиент, тем более эффективной будет ваша работа, т.к. вы сумеете изучить совершенные ранее ошибки, поймете слабые места проекта и сможете сэкономить время, используя чужой труд в тех областях, где он выполнен удовлетворительно.

- доступы в Яндекс.Метрика, Яндекс.Вебмастер

- доступы в Google.Analytics, Webmasters.Google

- логи сервера

- отчеты по SEO

- семантическое ядро

- выгрузка из бирж, или доступы туда

- информация о том, попадал ли сайт хоть когда-нибудь под фильтры

- информация о том, что меняли на сайте за последний год (два)

- информация о том, какими человеческими ресурсами располагает заказчик

- информация о том, какие результаты к каким срокам ожидает заказчик

- план развития проекта на ближайший год

- порядок внесения изменений на сайте

- контактные лица

- информация о том, как создаются новые страницы

- аудиты (+ТЗ), проводимые ранее

- есть ли другие сайты у компании, где продается та же или похожая продукция

- есть ли зеркала сайта, менялся ли хозяин домена

- логи всей переписки с Платоном Щукиным

1.2 Ручной анализ сайта

Необходимо вручную изучить сайт, стать его постоянным пользователем, зарегистрироваться, найти ошибки и столкнуться с теми проблемами, которые мешают посетителям решать свои проблемы.

- открыть большое количество разнообразных страниц сайта и изучить структуру, категории, шаблоны, наполнение, виды контента, проблемы, ошибки

- попытаться добавить спамный контент

- совершить основные действия пользователя

- изучить способы создания контента на сайте

- изучить регулярность публикаций на сайте и актуальность информации

- изучить работоспособность функционала и разделов сайта

1.3 Анализ отчетов о продвижении

Сопоставление отчетов с хронологией изменений алгоритмов поисковых систем, изменений на сайте, покупки ссылок и другими явлениями позволяет изучить и понять многие скрытые проблемы проекта.

- запросы, соответствие проблем страницам

- что было сделано, как это коррелируется с динамикой продвижения

- соответствие прогнозов результатам

- объяснение проблем и задержек в достижении результатов

- наличие и содержание рекомендаций по сайту

- наличие и содержание контрольных аудитов

1.4 Оценка трафикового потенциала сайта

Невозможно делать прогноз трафика, но можно оценить потенциал тематики и выполнить свою работу максимально эффективно.

- Изучение проблематики в тематике

- Изучение полноты охвата тематики на сайте

- Изучение содержания сайта

- Изучение трафиковых достижений успешных проектов

- Изучение трафикового потенциала контентных решений в тематике

Почему нельзя делать прогноз трафика приемлемой точности

- среда нестабильна: ошибки ПС, новые алгоритмы, фильтры, действия конкурентов, неполное представление об алгоритмах, машинное обучение

- сезонность и всплеск спроса: метеориты и пластиковые окна, лед и шины

- неисполнение обязательств со стороны клиента (текст не выложен, тз не внедрено)

- данные по статистике запросов основаны на прошлом опыте

- неизвестны все запросы, по которым придут посетители

- технологическое отставание специалистов - 6 мес. минимум

- ошибки SEO-специалиста, ошибки клиента, ошибки сторонних сервисов

- ошибки подрядчиков

- происки конкурентов

…

1.5 Анализ CMS на эффективность для продвижения

- CMS обновляется?

- Содержит ли CMS необходимые для такого типа проекта SEO модули?

- Не совершили ли разработчики критических ошибок?

- Проверка на использование стандартного шаблона в качестве дизайна сайта

1.6 Анализ начальной точки продвижения сайта

Для того, чтобы замерять эффективность, перед тем, как начинать продвижение сайта, необходимо обозначить начальную точку. Это так же позволит нам соотнести сайт с потенциалом тематики, замерив, например, разнообразие ассортимента.

- Кол-во рубрик: 15

- Кол-во карточек: ≈600-800

- Анализ позиций по всей семантики (A-Parser, https://www.seolib.ru/analytics/)

- Видимость_1 SUMM (wordstat/position) – грубо

- Видимость_2 SUMM (wordstat/k_ctr_position) – менее грубо

- Посещаемость сайта (Яндекс.Метрика, LiveInternet, Google.Analytics, https://seobudget.ru/visitors/, https://www.alexa.com/)

Часть #2 - Матрица сайта

Матрица – формат представления структуры сайта, удобный при изучении крупных проектов.

2.1 Матрица сайта

- по горизонтали категории сайта (ноутбуки, пылесосы)

- по вертикали шаблоны страниц (карточки товаров, каталог товаров)

- на пересечении типы страниц, представленные параметрами в URL (карточки пылесосов, каталог ноутбуков)

2.2 Ошибки

- перечисление всех страниц

- логические несоответствия

- матрица должна строиться на текущем состоянии сайта, а не планируемом

2.3 Особые случаи

- для небольшого сайта может быть всего 1 раздел

- "о компании", "контакты", "помощь" - это одна группа в матрице, а не 3 страницы

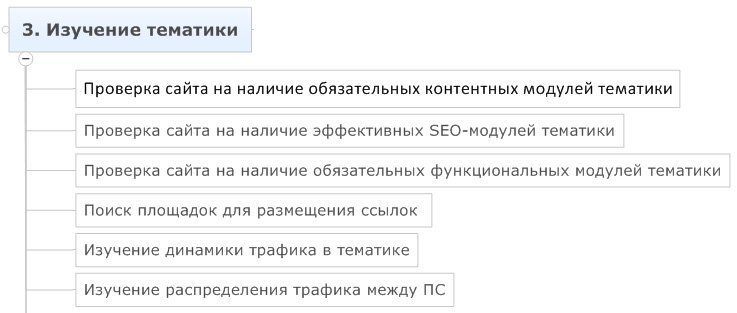

Часть #3 - Изучение тематики

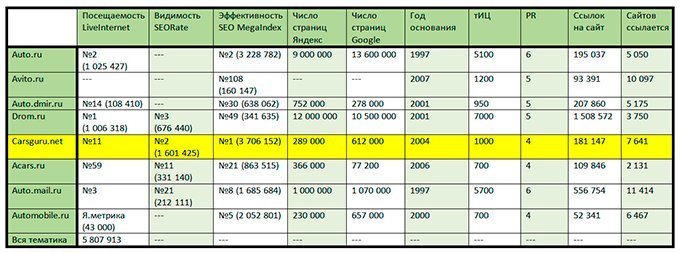

3.1 Выбор проектов для анализа

При изучении конкурентов рекомендуется отбирать лидеров в одном с вами сегменте, лидеров более узкого сегмента и лидеров более широкого сегмента. Так, если вы торгуете компьютерной техникой, то лидер в вашем сегменте будет успешным магазином компьютерной техники, более узкий сегмент может быть представлен магазином, где продаются только ноутбуки, а более широкий сегмент может представить онлайн-гипермаркет, который охватывает множество товарных категорий.

- изучение лидеров по LiveInternet

- изучение лидеров по SEORate

- изучение лидеров по MegaIndex

- изучение лидеров через https://www.seolib.ru/help/seoprice/

- сравнение отобранных проектов

На этой схеме видно, что все представленные проекты имеют существенный трафик, большое количество страниц, что делает проекты интересными для изучения. Лидер по поисковому трафику – проект carsguru.net. Для того, чтобы это выяснить, пришлось удалить в статистике витальные запросы, с их учетом лидер – auto.ru, который весьма плохо ранжируется в поисковых системах.

3.2 Составление списка возможных контентных модулей тематики

Для того, чтобы собирать трафик необходим контент. Кроме того, у посетителей есть определенные ожидания о том, какой контент должен быть на сайте. Например, на автомобильном портале многие посетители ожидают увидеть обзоры автомобилей.

- Форум

- Автозапчасти, тюнинг, шины, диски

- Расширение коммерческого раздела

- Каталог организаций

- ПДД, онлайн экзамены, штрафы

- Видео

- Тест-драйвы

- FAQ по автострахованию

- Автопутешествия

- Статьи

- Новости

3.3 Оценка потенциала аудитории контентных модулей

Чтобы расставить приоритеты по списку контентных модулей, необходимо учесть потенциал трафика, соответствие модуля концепции проекта, стоимость разработки.

- Отобрать запросы, характеризующие каждую проблематику и посчитать сумму wordstat

- ноутбуки (asus|acer|macbook|sony...) -драйверы -скачать -описание -чехол...

- (сумка|чехол|мышка|мышь|салфетки...) (+для ноутбука|+для нетбука)

- ...

- По Livelnternet посчитать отношение долей между поисковыми системами в данной тематике

- https://www.liveinternet.ru/stat/ru/computers/searches.html

- Строим пропорцию, считаем Google и Mail

- Вычесть взаимоисключающие значения, если они есть

- Ноутбуки - чехлы

Приблизительный потенциал по ноутбукам с экраном 17 дюймов

Запрос, введенный в Яндекс Wordstat:

ноутбуки 17 -характеристики -параметры -топ -сравнение -отзывы -аксессуары -обзоры -тесты -рейтинг -обсуждение -форум -драйвера -как -разобрать -работает -биос -камера -windows -ремонт -аккумулятор -какой -клавиатура -батарея -wifi -включить -разборка -видео -bios -разбор -блютуз -питание -программы -видеокарта -сумка -рюкзак -кейс -чехол -тысяч -руб –рублей

Полученный результат: 11799

Считаем потенциальный трафик в ведущих поисковых системах на основе полученных данных

- x/100*41 = 11799

- x/100 = 11799/41

- x/100 = 287,780487804878

x (общий потенциал трафика по 3 ПС) = 28778,0487804878 или 28778

ЯНДЕКС: 28778/100*41 = 11798,98 или 11799

GOOGLE: 28778/100*52 = 14964,56 или 14946

MAIL: 28778/100*4 = 1151,12 или 1151

Из работы Александра Вежнина, 8-ой поток профессионального курса

3.4 Согласование плана по развитию проекта со списком контентных модулей

При планировании развития интернет-проектов часто забывают об оценке потенциала. SEO специалист, используя известные ему инструменты помогает определить потенциал всех вариантов развития проекта, совместно с руководством проекта определяется приоритетность каждого модуля.

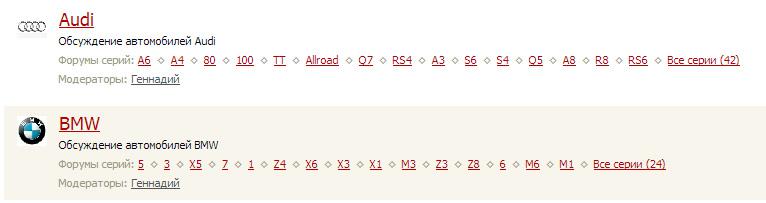

3.5 Изучение SEO-модулей, используемых лидерами в тематике

Каждая тематика по-своему уникальна, часто особенности находят отражение в технических решениях, используемых SEO-специалистами. Например форум на проекте carsguru.net уникален по своей структуре с точки зрения семантического ядра:

3.6 Составление списка SEO-модулей для сайта

Пример:- Перелинковка индексации

- Перелинковка статического веса

- Перелинковка анкорного веса

- Sitemap.xml на основе анализа логов сервера

- Проверка индексации страниц

3.7 Составление списка возможных функциональных модулей тематики

Наличие и качество исполнения функциональных модулей так же оказывает влияние на продвижение сайта. Так, к примеру, интернет-магазин по продаже ноутбуков, на котором нет функционала сравнения ноутбуков может потерять посетителей. Другой пример – возможность покупки в кредит. Если такой функционал на сайте не предусмотрен, возникнет отток на сайте и понижение поведенческих факторов.

3.8 Проверка сайта на наличие функциональных модулей тематики

Изучаем наличие и реализацию функциональных модулей на сайте, сопоставляем с успешными проектами и лидерами тематики.

3.9 Поиск площадок для размещения PR ссылок в тематике

- Тематические порталы

- Тематические СМИ

- Каталоги организаций

- Региональные площадки

- Изучение площадок с упоминаниями наиболее известных компаний в тематике

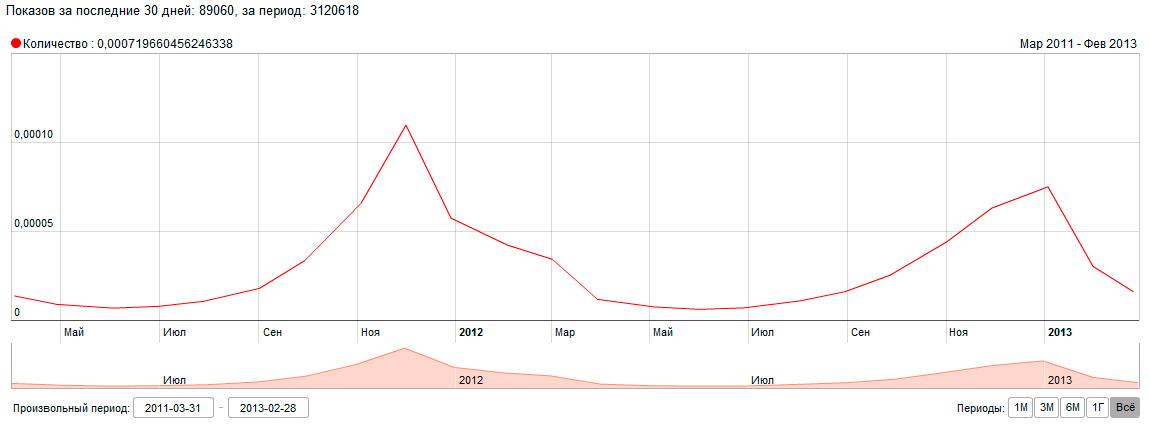

3.10 Изучение динамики трафика в тематике

Динамика нужна для того, чтобы оценить результаты роста за прошлый период. Возможно рост в абсолютных значениях в действительности был падением, если считать его относительно динамики роста рынка.

- wordstat.yandex.ru

3.11 Изучение распределения трафика между ПС

Прежде, чем продвигать сайт, необходимо оценить потенциал каждой поисковой системы. Есть тематики, где mail.ru может дать много трафика, есть тематики, где Google обгоняет Яндекс.

- liveinternet.ru

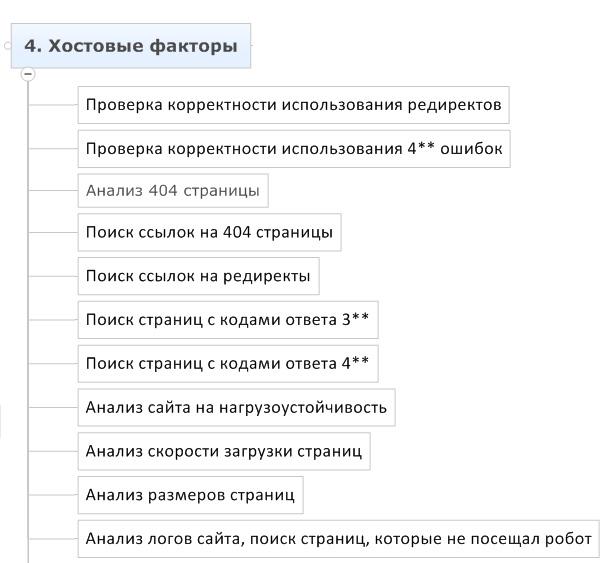

Часть #4 - Хостовые факторы

4.1 Проверка корректности использования редиректов

Ошибки при использовании редиректов могут привести к потере статического веса, смене входных страниц и даже выпадению сайта из индекса.

- Любой многошаговый редирект – ошибка

- Использование неверного типа редиректов – ошибка

- Внедрение внутренних редиректов без смены ссылок на новые адреса – ошибка

- Постановка редиректов между страницами с разным контентом – может быть ошибкой

- Использование редиректа вместо rel=canonical

- Редирект, конечной точкой которого является не 200-я страница

- Использование редиректов для отличающихся страниц

- Использование любых редиректов для robots.txt

- Использование редиректов на внешние сайты по внутренним ссылкам

4.2 Проверка корректности использования 4** ошибок

Наличие 404 ошибок может приводить к потере денег, снижению лояльности пользователей, выпадения части сайта из индекса и потерь статического веса.

- Страница не существует, но используется не 404 ошибка

- Страница существует, но используется 404 ошибка

- Страница должна быть удалена из индекса, но используется 404 вместо 410

- Страница поменяла адрес, но не поставлен редирект

4.3 Анализ 404 страницы

404 страница должна быть корректно оформлена, это позволит минимизировать потери трафика

- Страница должна иметь шаблон в дизайне сайта

- Страница должна давать возможность пользователю вернуться назад

- Страница должна давать возможность пользователю посетить важные разделы

- Страница должна отдавать код ответа 404

4.4 Исправление ошибок

Для того, чтобы исправить ошибки, необходимо их найти. В рамках большого сайта эту задачу невозможно решить без инструментов автоматизации.

- Поиск страниц с кодами ответа 3**

- Поиск ссылок на редиректы

- Поиск страниц с кодами ответа 4**

- Поиск ссылок на 404 страницы

- Сервисы, построенные на краулере, которые определяют откуда какая куда ссылка: СайтРепорт, PageWeight, Xenu

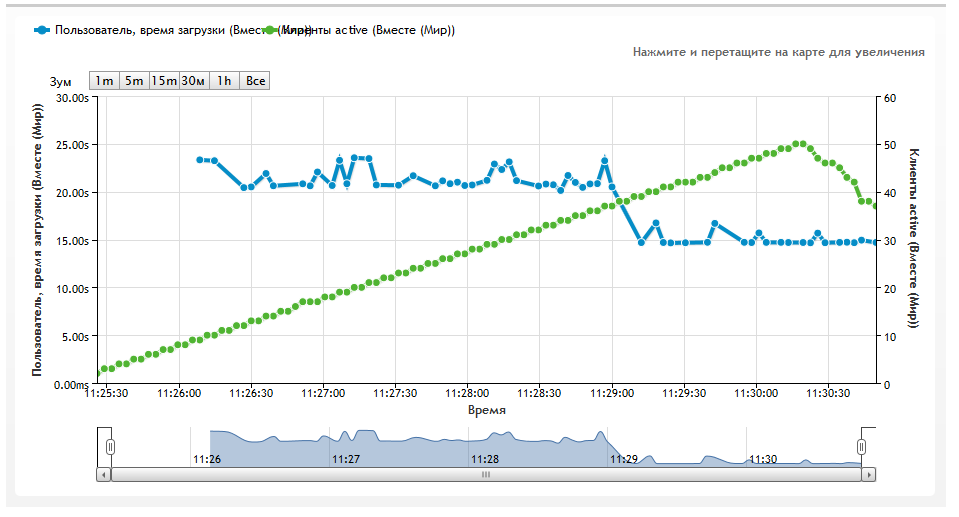

4.5 Анализ сайта на отказоустойчивость

Если не обеспечить сайту достаточные мощности, то с приходом трафика начнутся отключения сайта, пользователи будут получать информацию об ошибке.

4.6 Анализ скорости загрузки страниц

Скорость загрузки страниц влияет на конверсию и ранжирование. Воздействуя на код страницы, мощности и настройки сервера и CMS, необходимо увеличивать скорость загрузки страниц. Для измерения скорости существуют сервисы:

4.7 Анализ размеров страниц

Анализ крайних значений размеров страниц позволяет обнаружить неочевидные ошибки, например страницы с очень маленьким весом могут создаваться из-за ошибок CMS.

- анализ крайних значений по типам страниц и разделам сайта

- верстка должна быть оптимизирована, чтобы страницы грузились быстро

4.8 Анализ логов сайта, поиск страниц, которые не посещал робот:

Анализ логов позволяет понять, какие страницы посещал робот. Это важно, например, при работе над индексацией страниц. Бывает так, что страница посещается роботом, но в индекс не попадает.

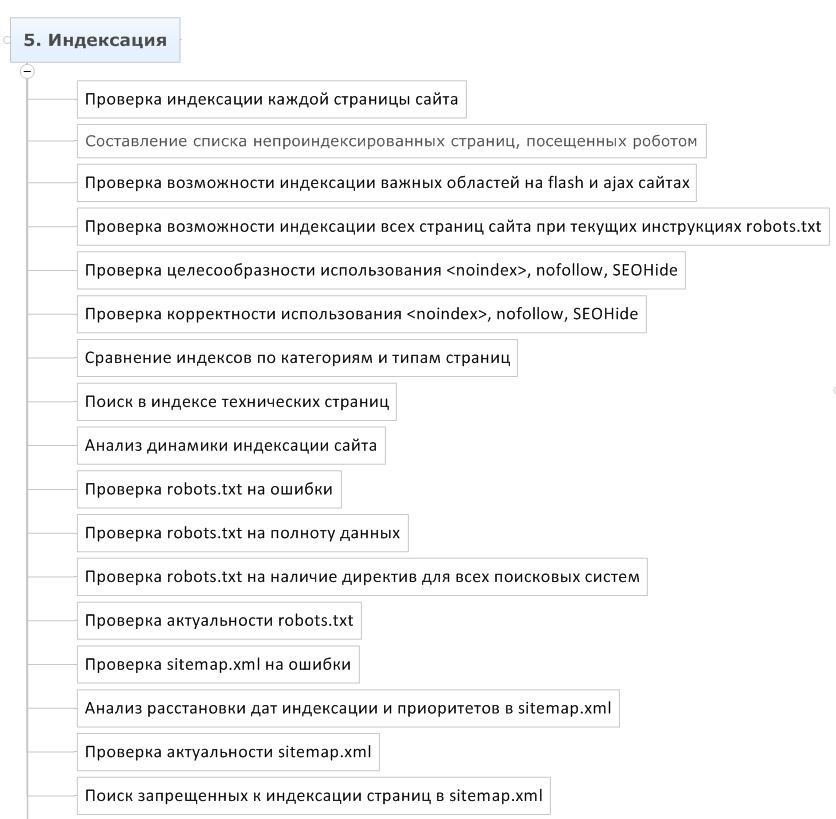

Часть #5 – Индексация

5.1 Проверка индексации каждой страницы сайта

Индексация особенно важна для больших проектов. Если в индекс попадают мусорные страницы (дубликаты, страницы с ошибками, пустые страницы), важные страницы (продвигаемые) получают меньше статического веса. Если в индекс не попадают важные страницы, сайт недополучает трафик.

- Составление списка всех важных страниц сайта (выгрузка из БД, ручное составление)

- Составить список всех страниц сайта (программы PageWeight или Xenu )

- Проверить все ссылки с помощью запросов url:https://www.site.ru/page/ и url:https://site.ru/page/, используя автоматический парсер ПС (программа a-parser)

- Составить 4 списка: все проиндексированные важные страницы, все проиндексированные мусорные страницы, все непроиндексированные важные страницы, все непроиндексированные мусорные страницы

5.2 Составление списка непроиндексированных страниц, посещенных роботом

В некоторых случаях, после посещения робота, страница не попадает в индекс. Важно отличать такие страницы, от страниц, которые не в индексе и робот их не посещал, поскольку технология индексации таких страниц отличается.

- При помощь анализа логов составляется список страниц, которые посещал робот

- Получить список важных непроиндексированных страниц, не посещенных роботом и список важных непроиндексированных страниц, посещенных роботом

- Изучить список непроиндексированных страниц, которые не посещал робот ПС, это будет список страниц, на которые необходимо привести робота, чтобы они попали в индекс

- Изучить список непроиндексированных страниц, которые посетил робот ПС, это будут страницы, которые имеют проблему с дублями или статическим весом

5.3 Проверка возможности индексации важных областей на flash и ajax сайтах

При продвижении творческих проектов важно изучить индексацию областей, при написании которых использовались технологии Flash, Ajax или другие, с индексацией которых могут возникнуть проблемы.

- Необходимо по матрице сайта открыть текстовую сохраненную копию всех типов страниц и найти там тексты, выложенные с помощью этих технологий, если текст найти удалось – значит блок индексируется

- В редких случаях даже при отсутствии flash и ajax, на сайте может быть настолько кривая верстка, что текст не попадет в текстовый индекс

5.4 Проверка возможности индексации всех страниц сайта при текущих инструкциях robots.txt

После корректировки robots.txt необходимо проверить, что все важные доступны для индексации.

- Проверка осуществляется сервисом https://webmaster.yandex.ru/robots.xml;

5.5 Проверка целесообразности использования noindex, nofollow, meta noindex, meta nofollow, SEOHide

Ошибки в инструкциях индексации могут привести к выпадению важных страниц из индекса и существенным потерям трафика.

- По матрице сайта делается проверка (сервисы RDS-bar, СайтРепорт)

- Необходимо найти не закрытые <noindex>

- Необходимо изучить, какие внутренние ссылки закрыты в nofollow

- Необходимо изучить, какие внешние ссылки закрыты в nofollow

- Необходимо изучить, какие страницы закрыты в meta noindex

- Необходимо изучить, какие страницы закрыты в meta nofollow

- Необходимо изучить, есть ли на сайте SEOHide и корректно ли он внедрен

5.6 Проверка корректности использования <noindex>, nofollow, SEOHide

После составления списка страниц, на которых используются инструкции по скрытию индексации, необходимо изучить списки на предмет ошибок. Контрольные точки:

- Не закрытый <noindex>

- Индексируемый SEOHide)

- Проверка корректности SEOHide с помощью плагина WebDeveloper

- Важные страницы с meta nofollow, meta noindex

- Nofollow на внутренних ссылках

5.7 Поиск ошибок (сравнение индексов по категориям и типам страниц)

Необходимо подробно изучить сайт на предмет ошибок. Один из способов это сделать – сравнить списки проиндексированных страниц в разных поисковых системах по тем разделам и типам страниц, где их количество в индексе различается.

- Изучаются области сайта, где в одной ПС страниц меньше, чем в другой)

- Открываются страницы из списка проиндексированных, изучаются

- Изучаются те страницы, которых нет в индексе одной из поисковых систем, но есть в другой поисковой системе

- Изучаются страницы в Google, помеченные как supplimental

5.8 Поиск в индексе технических страниц

Приведены популярные типы технических страниц, которые рекомендуется закрывать от индексации, а так же некоторые варианты идентификации их через оператор inurl:

- Файлы статистики /*_openstat

- Страницы контекстной рекламы или меток /*from=adwords, /*utm_source=, /*utm_campaign=, /*utm_content=, /*utm_term=, /*utm_medium=

- Корзина /cart/, /order/

- Страницы сортировки /*sort, asc, desc, list=*

- Страницы поиска /search/

- Страницы авторизации /auth/

- Версия для печати /*printable, /print

- Напоминание пароля /remind_password/

- Регистрация /register/

- Административный раздел - /administrator/

- Кэш страниц /cache/

- Модули, подгружаемые на страницы /components/, /plugins/

- Файлы инсталяции CMS /installation/, /installer/

- Логи /logs/

- Файлы /files/

- Скрипты, таблицы стилей /ajax/, /java/, /css/

- Аккаунты пользователей /user/

- ...

5.9 Анализ динамики индексации сайта

Динамика индексации сайта может указать на слабые места и проблемы проекта.

- Сведение статистики по списку проиндексированных страниц, собранных с параметром &how=tm позволяет нам узнать возраст страниц и изучить динамику индексации сайта

5.10 Проверка robots.txt на ошибки

Из-за ошибки в robots.txt весь сайт может быть исключен из индекса.

- С помощью сервиса https://webmaster.yandex.ru/robots.xml проверяем закрывает ли robots все ненужные страницы и не находит ли валидатор ошибок

- Проверяем, что robots.txt соответствует правилам https://help.yandex.ru/webmaster/?id=996567

5.11 Проверка robots.txt на наличие директив для всех поисковых систем

Яндекс и Google используют различные директивы в robots.txt, инструкции для них следует писать отдельными.

- User-Agent: Yandex + User-Agent: * обязательно, опционально User-Agent: Google

5.12 Проверка sitemap.xml на ошибки

С помощью sitemap.xml можно управлять индексацией своего сайта. Для того, чтобы поисковые системы доверяли рекомендациям и корректно обрабатывали их, необходимо исправить ошибки.

- Ссылка на sitemap.xml есть в robots.txt

- Атрибуты дат страниц расставлены корректно

- Приоритеты расставлены правильно

- Исключены уже проиндексированные страницы

- Нет страниц, закрытых от индексации в robots.txt

- Нет нарушений валидности составления sitemap.xml (сервис https://webmaster.yandex.ru/sitemaptest.xml)

- - Дополнительная информация по sitemap.xml - https://www.sitemaps.org/ru/faq.html#faq_xml_schema

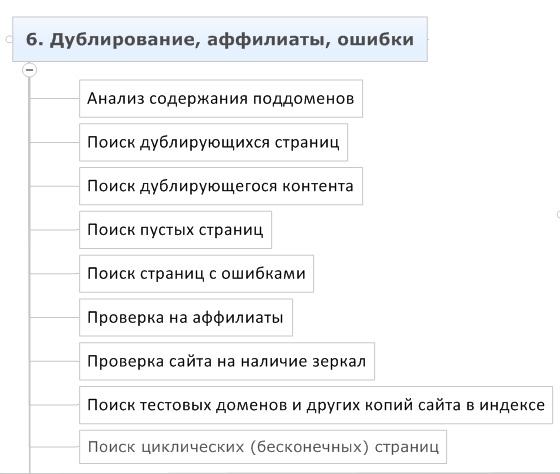

Часть #6 - Дублирование, аффилиаты, ошибки

6.1 Анализ содержания поддоменов

На поддоменах может располагаться что угодно: копия сайта, спамный контент, вирусы. Например, на поддомене может располагаться архивная версия форума, которая уже не работает и поэтому не обновляется. Используя найденные ошибки в движке форума, которые не были исправлены, спамботы могут оставить на страницах форума ссылки на спамные ресурсы. Необходимо внимательно изучить содержание поддоменов до начала продвижения сайта.

- получив список поддоменов, изучить из содержание через site:1.site.ru

- rhost:ru.site*

- предмет изучения – поиск лишних доменов, уязвимостей, дублей, спамного и ошибочного контента

- предмет изучения – поиск лишних доменов, уязвимостей, дублей, спамного и ошибочного контента

6.2 Поиск дублирующих страниц

Необходимо найти все возможные дубли страниц сайта и перенастроить сервер таким образом, чтобы только 1 страница главного зеркала была индексируемой.

- сравнение по шинглам (сервис СайтРепорт)

- равнение TITLE (сервис СайтРепорт, WebMaster Google, оператор «intitle:» в Яндексе)

- проверка по дублям: www.site.ru и site.ru

- проверка по дублям: https:// и https://

- проверка по дублям: dir и dir/

- проверка по дублям: / и /index.php

- проверка по дублям: /cat/dir/ и /dir/cat/

- проверка по дублям: /cat/dir/id/ и /cat/id/

- проверка по дублям: panasonic/tv/ и param_1=12¶m_2=44

- проверка по дублям: param_1=12¶m_2=44 и /cat_12/dir_44/

- проверка по дублям: site.ru и test.site.ru

- проверка по дублям: test.site.ru и site.ru/test/

- проверка по дублям: /bedroom/divan_roza.html и /guestroom/divan_roza.html

- проверка по дублям: /?red_id=3342

- проверка по дублям: /session_id=442424424022492

6.3 Поиск дублирующего контента

На сайте могут присутствовать частичные дубли. Такие страницы не только соревнуются между собой в релевантности по ключевым словам дублированного блока, но и могут терять релевантность по продвигаемым запросам за счет размытия текста.

- сравнение по шинглам (сервис СайтРепорт)

- ручной осмотр разных страниц сайта по матрице)

6.4 Поиск пустых страниц

На некоторых сайтах можно найти страницы с пустыми TITLE. При таком раскладе продвигаемые страницы теряют в релевантности, потому что содержимое TITLE имеет значительное влияние на ранжирование страницы.

- по TITLE(сервис СайтРепорт)

- по количеству контента и по размеру страницы (часто пустые страницы и страницы с ошибками имеют проблемы в TITLE)

6.5 Поиск страниц с ошибками

Из-за ошибок CMS, базы данных, кодировки, верстки, скриптов и др., некоторые страницы могут отображаться с ошибками.

- вручную при сравнении индексов

- через поиск ключевых слов “admin”, “SQL” и т.п. в тексте

- анализ ошибок в логах

- анализ страниц с высоким % отказов

6.6 Поиск циклических (бесконечных) страниц

Некоторые модули сайта могут создавать циклические страницы. Так, например распространенный модуль календаря мероприятий позволяет создавать бесконечное количество страниц, углубляясь в даты до эпохи динозавров и ещё дальше.

- Анализ подозрительных модулей (календарь)

- Анализ страниц с высоким уровнем вложенности (сервис СайтРепорт)

6.7 Проверка на аффилиаты, зеркала, тестовые поддомены

При продвижении сайта может возникнуть неловкая ситуация, когда после достижения результатов поисковая система склеит несколько сайтов клиента между собой

- Проверка данных whois (сервис https://nic.ru/whois/)

- Поиск аффилиатов по контактным данным и whois (сервисы https://www.skvotte.ru/, https://2ip.ru/domain-list-by-email/, https://www.recipdonor.com/infowhois)

- Поиск всех проекты на этом IP (запрос IP:255.255.255.255 в Yahoo)

- Поиск по дублированию контента

- Совпадения между проектами по контактным данным и адресам организации

- Совпадения между проектами по контенту

- Совпадение между проектами по информации о владельцах домена

- Совпадение между проектами по реквизитам, адресу самовывоза, колл-центру

- Ссылки между проектами

- Совпадение между проектами по ассортименту и ценовым предложениям

- Совпадения между проектами по IP

- Пытка клиента

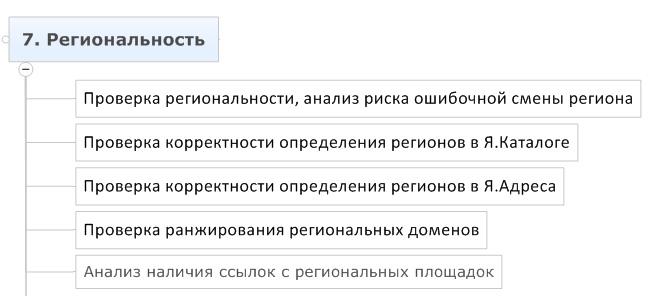

Часть #7 - Региональность

7.1 Ошибки при определении региона

Существует ряд признаков, по которым поисковые системы определяют регион сайта. Иногда регион может быть определен с ошибкой, например, был случай, когда сайту клиники доктора Александрова присвоили регион Александров. Общение с коллегами показало, что случай этот не единичный.

- Слово, схожее с названием региона в важных областях страницы

- Недобавление поисковой системой нужного региона в список регионов сайта

- Отсутствие указания явных региональных признаков на сайте

7.2 Проверка корректности определения регионов в Я.Каталоге

Я.Каталог – один из способов привязки региона к сайту.

- Проверить, какой регион присвоен сайту в Яндекс.Каталоге

7.3 Проверка корректности определения регионов в Я.Адреса

Если у компании есть представительства в разных городах – следует указать это через панель Яндекс.Вебмастер, добавив адреса всех представительств.

- Проверить, какие регионы добавлены как представительства в Я.Адреса

7.4 Проверка ранжирования региональных доменов

Сайт может хорошо ранжироваться в одном регионе и плохо в другом. Для того, чтобы понять, над какими городами нужно работать, необходимо собрать статистику по видимости сайта во всех продвигаемых регионах.

- Изучение ранжирования сайта по регионам по всей семантике

7.5 Анализ наличия ссылок с региональных площадок

Для хорошего ранжирования по регионам необходимо получить ссылки с региональных площадок. Многие площадки дают возможность поставить ссылку условно бесплатно.

- Поиск площадок, где лидеры размещают статьи, пресс-релизы и т.п. по соотв. регионам

7.6 Разделение сем. ядра на регионально зависимые и регионально независимые запросы.

Чтобы эффективно продвигать сайт в регионах, необходимо иметь представление, по каким запросам выдача различается, а по каким нет.

- Проверка семантического ядра на регионально-зависимые запросы (сервис https://www.seolib.ru/script/geo/)

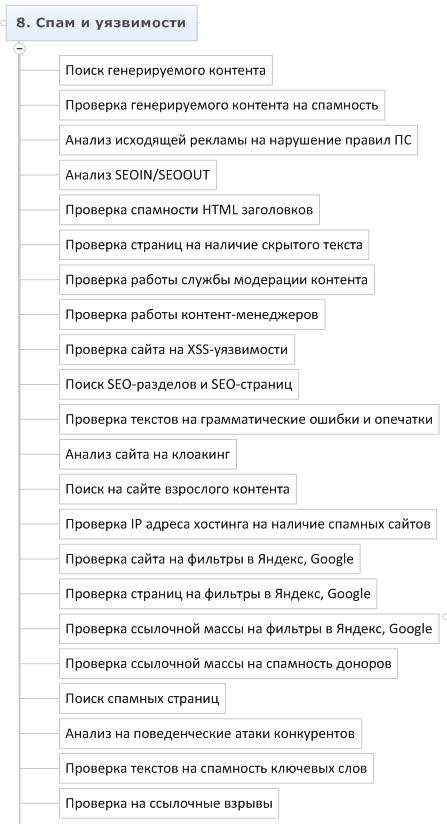

Часть #8 - Спам и уязвимости

8.1 Поиск генерируемого контента

Контент, сгенерированный автоматически, с высокой долей вероятности будет расценен поисковой системой как спамный. Необходимо изучить сайт на предмет такого контента:

- ручной поиск блоков с генерированным контентом по матрице

8.2 Проверка генерируемого контента на спамность

Если при генерации контента соблюдать определенные правила, он не будет расценен как спам. Необходимо изучить технологию генерации контента:

- изучение содержания блоков с генерируемым контентом

- изучение генерируемого контента на вопрос решения проблем пользователей

- запрос и изучение ТЗ от клиента, по которому реализованы модули генерации

8.3 Анализ исходящей рекламы на нарушение правил ПС

Согласно лицензии поисковой системы Яндекс, сайт, использующий рекламу, мешающую пользователю находить нужную ему информацию будет понижен в ранжировании.

- попапы

- тизеры

- рич медия

- редиректы

- кликандеры

- любые всплывающие окна

8.4 Анализ SEOIN/SEOOUT

При простановке ссылок важно учитывать значения SEOIN/SEOOUT, чтобы избежать фильтрации на вес входящей ссылки.

- SEOIN > SEOOUT (сервисы RDS bar, Solomono)

- Количество исходящих ссылок < количество страниц в индексе (сервисы RDS bar, Solomono, плагин Wink)

8.5 Проверка ошибок и спамности HTML заголовков

TITLE и H1, H2, …, H6 могут быть заспамлены как намеренно, так и случайно. Необходимо изучить содержание TITLE и H1 – H6 по всему сайту.

- слишком длинные заголовки (бонус получают не все слова)

- дублирование title, дублирование h1

- множественный повтор ключевых слов (окна, окна, окна)

- использование заголовков не по назначению (ссылки в меню, выделение жирным)

- несколько h1

- отсутствие заголовков

- отсутствие ключевых слов в заголовках

- отсутствие связи между текстом и заголовками

- совпадение title и h1

8.6 Проверка страниц на наличие скрытого текста

На странице может быть спамный или важный контент в невидимой области, например скрыт при помощи CSS и JavaScript. В случае, к примеру, наличия скрытых спамных ссылок, сайт может быть пессимизирован.

- HTML анализ страницы и поиск блоков скрытого текста

- Визуальный анализ страницы и CTRL + А

- Плагин WebDeveloper для Firefox

- Плагин Wink показывает скрытые ссылки со страницы

- Сервис СайтРепорт показывает все внешние ссылки с сайта

8.7 Проверка работы службы модерации контента

В результате действий модератора, систематически допускающего на сайт спамные объявления, сайт может быть пессимизирован. На моей практике был такой случай.

- поиск по спамным словам в индексе (порно, диплом, скачать, бесплатно, виагра, adult, viagra, free, blowjob, sex, movies)

- проверка: ручное добавление спамного контента

- установка плагина, автоматически определяющего спамные комментарии (сервис https://api.yandex.ru/cleanweb/)

8.8 Проверка работы контент-менеджеров

Неподготовленный контент-менеджер может допустить серьезную ошибку. Важно изучить работу контент-менеджера и подготовить для него инструкции.

- не копирует ли контент-менеджер из word в визуальный редактор

- публикует ли контент-менеджер через <HTML> или через визуальный редактор

- выдерживает ли контент-менеджер оформление текста по стандартам

- кроссбраузерны ли опубликованные страницы

- не создаются ли дубли контента

- нет ли на сайте индексируемых черновиков контента

- проверяет ли контент-менеджер поставленные ссылки

- контент-менеджер учитывает SEO нужды

8.9 Поиск SEO-разделов, SEO-страниц и архивной версии сайта

На старых сайтах иногда можно встретить пережитки прошлого: скрытый от пользователей раздел для SEO, архивная (старая) версия сайта, на которую не стоит ссылок. Важно убедиться, что эти страницы запрещены для индексации.

- Изучить по html карте сайта, какие есть категории, сколько там страниц, какие там урл

- Ручное изучение списка входных страниц

- Сравнение списка страниц в индексе со списком страниц, найденных краулером (a-parser vs xenu)

8.10 Проверка сайта на XSS-уязвимости

Если сайт имеет уязвимости, он может быть заражен вирусом, может произойти утечка персональных данных пользователей, его могут использовать для простановки спамных ссылок.

- Проверка с помощью сервиса Acunetix Web Vulnerability Scanner

- Проверка по чек-листу https://www.owasp.org/index.php/XSS_Filter_Evasion_Cheat_Sheet

8.11 Проверка текстов на грамматические ошибки и опечатки

Наличие орфографических и грамматических ошибок снижает доверие пользователей к сайту.

- Проверка орфографии с помощью сервиса https://www.webmaster.yandex.ru/spellcheck.xml

8.12 Анализ сайта на клоакинг

Некоторые вебмастера всё ещё используют клоакинг с целью манипуляции поисковой системой. Необходимо проверить сайт

- Сравнение кеша страницы с текущей версией

- Сравнить содержание страницы с копией от СайтРепорт (по умолчанию представляется user-agent: YandexBot)

- Поиск клоакинга в продаваемых ссылках

- Поиск клоакинга в контенте

8.13 Изучение списка исходящих внешних ссылок

Важно убедиться, что с сайта не стоит несанкционированных ссылок и ссылок на спамные сайты, в частности, что сайт не продает ссылки через биржи.

- получение списка ссылок на внешние сайты с помощью сервисов solomono, СайтРепорт

- поиск спамных сайтов и несанкционированных ссылок

8.14 Проверка IP адреса хостинга на наличие спамных сайтов

На IP адресе могут располагаться спамные и забаненные сайты. Об их наличии и содержании лучше узнать сразу.

- проверка через запрос ip:255.255.255.255 в Yahoo, где 255.255.255.255 – адрес сервера

8.15 Проверка сайта на фильтры в Яндекс, Google

Сайт может находиться под санкциями. Различают достаточно большое количество фильтров, но их можно объединить условно в 3 группы: фильтр на домен, фильтр на страницу, фильтр на ссылку.

- Падение позиций сайта (изучение динамики изменений позиций сайта на длительном периоде)

- Выпадение страниц из индекса (изучение динамики индексации сайта)

- Обнуление или уменьшение значений тулбарных метрик (изучение тИЦ и PR)

- Падение трафика (изучение данных Яндекс.Метрика, Google.Analytics)

- Информеры ПС (изучение данных Яндекс.Вебмастер, Google.Webmaster)

- Факт исключения или недобавления сайта в каталог Яндекса (проверка в скрытой части Яндекс.каталога через запрос https://bar-navig.yandex.ru/u?ver=2&url=https://site.ru&show=1)

8.16 Проверка страниц на фильтры в Яндекс, Google

SEO-специалист, который ранее продвигал сайт, мог перестараться с оптимизацией продвигаемых страниц.

- Падение позиций запроса или группы запросов (изучение динамики изменений позиций по запросам и группам запросов на длительном периоде)

- Наличие страницы в индексе

8.17 Проверка ссылочной массы на фильтры в Яндекс, Google

Ошибки SEO специалиста могли привести к тому, что закупка части ссылок приносит убытки.

- Обнуление тИЦ

- По купленным проиндексированным ссылкам позиции не растут

- Позиции по запросам падают или стагнируют

8.18 Проверка ссылочной массы на спамность доноров

Проверить рабочесть конкретной ссылки невозможно, но можно исключить подозрительные сайты из ссылочной массы.

- Трафик

- SEOin vs SEOout

- Отношение числа ссылок к числу страниц в индексе

8.19 Поведенческие накрутки

Важно узнать, не предпринимаются ли осознанные или не осознанные действия по накрутке поведенческих факторов.

- Не обоснованный рост трафика по некоторым запросам, опережающий рост позиций (или вообще при отсутствии роста позиций) (сервисы Яндекс.Метрика, Google.Analytics)

- Рост трафика при отсутствии роста конверсии (сервисы Яндекс.Метрика, Google.Analytics)

8.20 Проверка текстов на спамность ключевых слов

Страницы с заспамленными текстами могут быть пессимизированы

- использовать любой сервис, который строит график распределения ключевые слова (функция page auditor в СайтРепорт, лексикологический анализ в СайтРепорт, )

8.21 Проверка IP на наличие в спам.базах

IP адрес, на котором расположен сервер заказчика, с которого уходят уведомления о регистрациях и рассылка для пользователей, может быть в спам-листах.

- Проверка через сервис https://2ip.ru/spam/

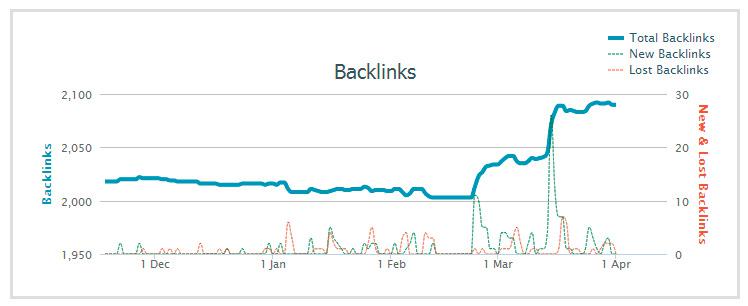

8.22 Проверка на ссылочные взрывы

Неквалифицированный SEO специалист может закупить непропорционально большое количество ссылок за короткий период, вызвав эффект «ссылочного взрыва». В этом случае купленные в определенный период ссылки перестают учитываться и бюджет расходуется впустую.

- Проверка через сервис https://majesticseo.com/

- Проверка через сервис https://ahrefs.com/

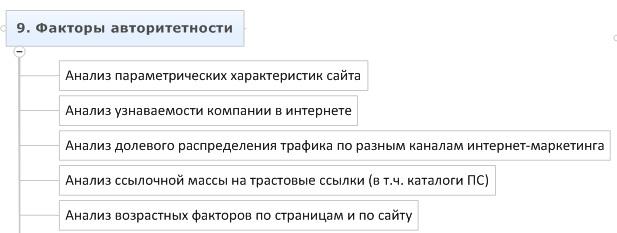

Часть #9 - Факторы авторитетности

9.1 Анализ параметрических характеристик сайта

Нужно изучить косвенные показатели авторитетности и статического веса сайта и страниц, чтобы оценить начальное положение сайта и динамику его роста.

- тИЦ (RDS Bar)

- PR (RDS Bar)

- AlexaRank (сервис www.alexa.com)

- места в различных рейтингах (Liveinternet, Megaindex, SeoRate)

- присутствие сайта в каталогах Яндекс, DMOZ, Mail.ru

9.2 Анализ узнаваемости компании в интернете

Один из показателей авторитетности проекта – активность в интернете.

- статистика по витальным запросам (сервис wordstat.yandex.ru)

- количество упоминаний названия компании и домена в интернете (запросы к Яндексу)

- наличие в значимых тематических рейтингах (например для SEO – это ktoprodvinul.ru, seonews.ru, cmsmagazine.ru)

- упоминание в блогах, новостях (запросы к Яндексу)

9.3 Анализ долевого распределения трафика по разным каналам интернет-маркетинга

Необходимо изучить все источники трафика на сайт. Некоторые из этих источников можно использовать для получения ссылок. Во время анализа часто можно обнаружить ошибки вебмастеров и маркетологов, приводящие к падению конверсии.

- анализ проводится через сервисы Яндекс.Метрика и Google.Analytics

- изучение трафика, конверсия, сравнение между категориями сайта и разными источниками трафика

9.4 Анализ ссылочной массы на трастовые ссылки (в т.ч. каталоги ПС)

Основной параметр релевантности – TrustRank строится на ссылках с авторитетных ресурсов. Необходимо изучить сайт на наличие таких ссылок.

- получение списка сайтов (ahrefs, majesticseo, solomono)

- изучение площадок по выборки с высокими тИЦ, PR, в Як или DMOZ

9.5 Анализ возрастных факторов по страницам и по сайту

Нас интересует: возраст ссылок, возраст страниц, возраст сайта.

- Возраст сайта можно узнать через whois (https://nic.ru/whois)

- Изучить историю домена (https://web.archive.org/)

- Изучение истории индексации https://yandex.ru/yandsearch?text=запрос&lr=213&how=tm

- Изучение дат последней индексации страниц со ссылками (сохраненные копии в ПС)

- Сопоставление дат индексации страниц со ссылками и дат простановки ссылок

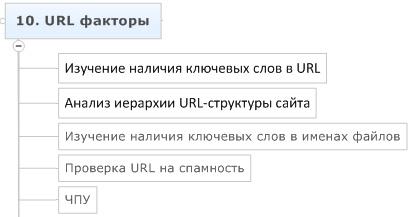

Часть #10 - URL факторы

10.1 Изучение наличия ключевых слов в домене

Наличие ключевого слова в имени домена оказывает значительное влияние на ранжирование.

- проверить вручную наличие основных ключевых слов в имени домена

10.2 Изучение наличия ключевых слов в URL

Наличие ключевого слова в URL оказывает влияние на ранжирование.

- получить список всех URL сайта

- изучить алгоритм формирования URL

- изучить список всех URL сайта на наличие ключевых слов в URL

10.3 Анализ иерархии URL-структуры сайта

По URL пользователь должен понимать, где находится, а поисковая система должна видеть вложенность страниц между разделами и принадлежность страницы к определенному типу.

- получить список всех URL сайта

- изучить иерархию вложенных групп

- проверить наличие отличительных признаков типов страниц в URL

10.4 Изучение наличия ключевых слов в именах файлов

Документы .jpeg, .pdf, .doc и другие так же собирают трафик. Наличие ключевого слова в названии файла – важный фактор ранжирования.

- проверить наличие соответствующих ключевых слов по документам html, php, jpeg, pdf, doc, pptx и др.

10.5 Проверка URL на спамность

SEO специалист может переборщить со стремлением разместить ключевые слова в URL, сделав URL спамными.

- ключевое слов встречается не более 2 раз, если 1 раз - в домене

- если в домене ключевого слова нет, оно встречается в URL не более 1 раза

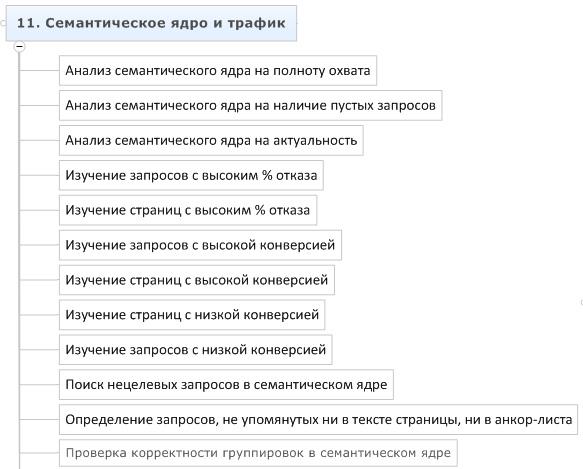

Часть #11 - Сематическое ядро

11.1 Анализ семантического ядра на полноту охвата

Очень важно, чтобы семантическое ядро охватывало максимально возможное количество проблем пользователей и запросов, формирующих эти проблемы.

- семантическое ядро охватывает весь ассортимент клиента?

- семантическое ядро охватывает все проблемы целевой аудитории?

11.2 Анализ семантического ядра на наличие пустых запросов

В семантическом ядре часто оказываются пустые запросы. Пример таких запросов – «квартира под ключ», «белый бриллиант».

- считаем значение wordstat по всему семантическому ядру

- считаем значение «!wordstat» по всему семантическому ядру

- строим пропорцию «!wordstat»/wordstat

- проверяем вручную всё, что меньше 5%

11.3 Анализ семантического ядра на актуальность

Ассортимент сайта и спрос пользователей постоянно меняются. Если семантическое ядро делалось год назад – оно уже не актуально, посчитано по устаревшим данным и не учитывает новых запросов и новых проблем пользователей.

- соответствует ли текущий ассортимент сайта семантике

- как давно собиралось семантическое ядро, изменилась ли среда

- появились ли возможности поиска новых запросов (напр. новая версия базы Пастухова)

11.4 Изучение запросов с высоким % отказа

Запросы могут находиться на хороших позициях, но не приносить никакой выгоды при высоком % отказов. Необходимо обнаружить такие запросы и устранить причины проблем.

- получение выгрузки из Яндекс.Метрика или Google.Analytics по запросам

- подготовка среза запросов по семантическому ядру с высоким % отказов

- изучение пар запрос-входная страница

11.5 Изучение страниц с высоким % отказа

Необходимо так же изучить страницы с высоким % отказов, т.к. причины могут быть связанны не с парой запрос-документ, а крыться в ошибках и недоработках самого документа.

- получение выгрузки из Яндекс.Метрика или Google.Analytics по запросам

- подготовка среза страниц с высоким % отказов

- изучение страниц

11.6 Изучение запросов с высокой конверсией

Большой интерес представляют запросы, дающие высокую конверсию. Изучение природы возникновения такой конверсии позволяет определить приоритеты при продвижении проекта.

- получение выгрузки из Яндекс.Метрика или Google.Analytics по страницам

- подготовка среза страниц с высокой конверсией

- подготовка среза страниц с высокой конверсией

11.7 Изучение страниц с высокой конверсией

Необходимо изучить так же страницы, имеющие высокую конверсию

- получение выгрузки из Яндекс.Метрика или Google.Analytics по страницам

- подготовка среза запросов по семантике с высокой конверсией

- изучение страниц

11.8 Изучение страниц с низкой конверсией

Низкая конверсия может быть не связана с % отказов. Необходимо отдельно изучить причины этой проблемы.

- получение выгрузки из Яндекс.Метрика или Google.Analytics по страницам

- подготовка среза страниц с низкой конверсией

- изучение страниц

11.9 Изучение запросов с низкой конверсией

Необходимо изучить так же запросы, имеющие низкую конверсию.

- получение выгрузки из Яндекс.Метрика или Google.Analytics по страницам

- подготовка среза запросов с низкой конверсией

- изучение страниц

11.10 Определение запросов, не упомянутых ни в тексте страницы, ни в анкор-листа

На сайте могут быть страницы, которые не содержат в тексте или входящих ссылках ключевых слов из продвигаемых запросов.

- проверить по всему списку пар запрос-документ url:https://site.ru/page.html "key" (сервис a-parser)

11.11 Проверка корректности группировок в семантическом ядре

Каждый запрос должен встречаться только 1 раз, каждая проблема должна быть вынесена на отдельную страницу. Эти простые правила редко соблюдаются при разработке и продвижении сайта.

- вручную изучается группировка по выборочным разделам семантического ядра)

- ищутся дубликаты запросов (excel)

11.12 Определение коммерчески эффективных продуктов

Ключевая метрика в SEO – прибыль для клиента. Сопоставив данные о конверсии страниц, размере спроса, конкуренции и прибыльности товара, можно определить приоритеты в продвижении и контекстной рекламе.

- получение выгрузки данных о конверсии страниц

- изучение конкуренции по каждому запросу

- получение данных о прибыльности товара

- получение данных о размере спроса (wordstat.yandex.ru)

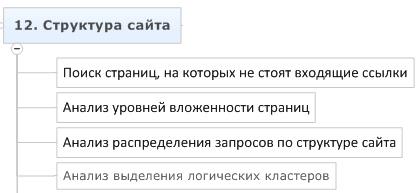

Часть #12 - Структура сайта

12.1 Поиск страниц, с которых не стоят исходящие ссылки

Если со страницы не стоит исходящих ссылок, она образует висячий узел и нарушает естественное распределение весов между страницами сайта. Все висячие узлы следует либо привести к виду обычных страниц, либо удалить.

- нужно найти висячие узлы. Найти их можно через сервис СайтРепорт, посмотрев список всех страниц, с которых нет ни одной исходящей ссылки.

12.2 Анализ уровней вложенности страниц

Распределение страниц по уровням вложенности играет важную роль в управлении статическим весом.

- распределение страниц по уровням вложенности

- наличие и происхождение страниц более 3 уровня вложенности

- наличие и происхождение страниц более 5 уровня вложенности

- изучение крайних значений уровней вложенности

12.3 Анализ распределения запросов по структуре сайта

Важно, чтобы приоритеты продаж соответствовали приоритетам привлечения клиентов.

- соответствуют ли коммерческие приоритеты продаж стратегии SEO

- все ли разделы охвачены семантикой, нет ли необоснованного перекоса

12.4 Анализ выделения логических кластеров

Корректная структура сайта позволяет по URL понять содержимое страницы.

- можно ли по URL определить, где сейчас находится пользователь

- вложены ли страницы логически (нет ли, к примеру, карточки товара, которая вложена не в свою категорию, а в главную страницу)

12.5 Как формировалась структура

В первую очередь важно, чтобы структура сайта соответствовала реальным проблемам пользователей, чтобы содержимое страниц было основано на изучении спроса.

- при разработке сайта проводилось ли маркетинговое исследование спроса

- находят ли текущие проблемы пользователей отражение в структуре сайта

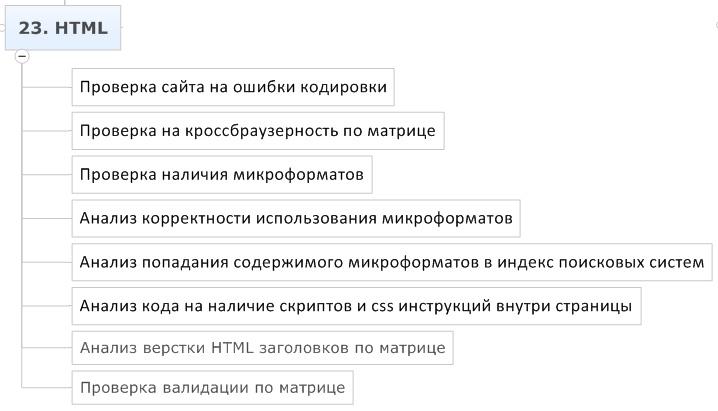

Часть #13 - HTML

13.1 Проверка сайта на ошибки в HTML

Существует свод правил, используя которые, поисковые системы распознают верстку на сайте. Например, тег H1 выделяет главный заголовок в тексте страницы. Некоторые специалисты используют теги не по их истинному назначению, например, выделяя с помощью тега H1 элементы меню.

- проверка валидности по матрице с помощью сервиса https://validator.w3.org/

- проверка соответствия кодировки содержимого документа его заголовку

- проверка на отсутствие закрывающих тегов

- проверка наличия нескольких H1

- изучение корректности использования и содержания H1-H6

- изучение наличия корректных ALT для картинок

- проверка наличие спамных <strong>, <b>, <em>, <i>

13.2 Проверка на кроссбраузерность по матрице

Страницы сайта должны корректно отображаться на всех популярных платформах, иначе часть пользователь не сможет пользоваться сайтом, что негативно скажется на конверсии и поведенческих факторах.

- firefox, opera, chrome, ie

- 1024, 1280, 1960

- ipod, iphone

- полный экран, стандартный экран, свернутый экран

13.3 Проверка наличия микроформатов

С помощью микроформатов можно передавать поисковой системе расширенные данные о содержании сайта, контактную информацию, отзывы, информацию о товарах.

- hCard — формат разметки контактной информации

- hRecipe — формат для описания кулинарных рецептов;

- hReview — формат разметки отзывов;

- hProduct — формат разметки товаров.

13.4 Анализ корректности использования микроформатов

При использовании микроформатов могут быть допущены ошибки.

- правила использования микроформатов https://microformats.org/wiki/Main_Page-ru

- проверка валидации микроформатов с помощью https://webmaster.yandex.ru/microtest.xml

13.5 Анализ попадания содержимого микроформатов в индекс поисковых систем

Не всегда корректные данные микроформатов учитываются поисковыми системами. Например, Google может посчитать отзывы в микроразметке не настоящими, и не учитывать их при формировании сниппета.

- учлось ли содержание микроформатов при формировании сниппетов;

13.6 Анализ кода на наличие скриптов и css инструкций внутри страницы

Вынесение кода в отдельные файлы позволяет оптимизировать работу сервера, расход трафика и скорость загрузки страниц.

- разбираем html по матрице, проверяем, что код css инструкций и скриптов хранится в отдельных файлах, а не коде страницы

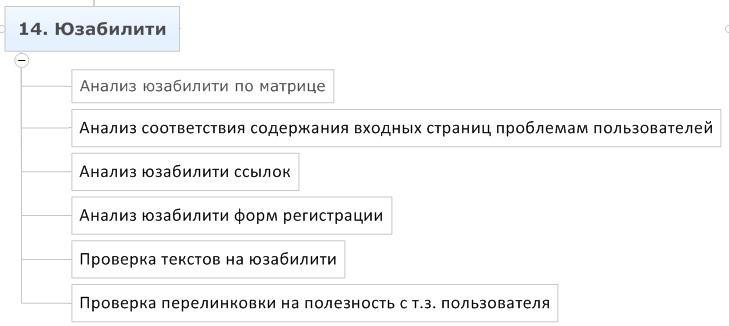

Часть #14 – Юзабилити

Вкратце о юзабилити

- изучить, что нужно пользователю

- убрать все лишнее

- добавить необходимое

- оформить наглядно

14.1 Составление матрицы юзабилити

Нужно понять, какие проблемы испытывают пользователи, приходящие на сайт, что на сайте помогает решить эти проблемы, а что мешает.

- уточнение, какие проблемы пользователи могут решить на каждом шаблоне по матрице

- уточнение, какие дополнительные проблемы возникают у пользователей

- описание списка элементов, которые присутствуют на странице

- изучение опыта успешных проектов в тематике, описание списка элементов, которые присутствуют на страницах у других проектов

- описание списка элементов, которые необходимы для решения ключевой и дополнительных проблем

14.2 Анализ соответствия содержания входных страниц проблемам пользователей

Анализируя полученные данные, необходимо понять, что убрать, а что добавить на входных страницах.

- описание списка элементов, которые не нужны для решения проблемы, но присутствуют на странице

- описание списка элементов, которых нет, но они необходимы для решения проблемы

14.3 Анализ юзабилити ссылок

Правила юзабилити не являются жесткими, профессионалы интерфейсов могут смело нарушать их и делать удобные сайты, но для среднестатистического проекта стоит придерживаться простых правил:

- ссылки подчеркнуты

- ссылки не выглядят так же, как текст

- ссылки, действие которых происходит в том же окне, имеют прерывистое подчеркивание

- очевидно, что за ссылкой кроется выпадающее меню

- границы ссылок и кнопок должны быть очевидны

- ссылка «купить» должна быть кнопкой

14.4 Анализ юзабилити форм регистрации

На странице регистрации / оформления заказа происходят очень большие потери пользователей. Одна из причин – сложность и запутанность регистрации, необходимость предоставления большого количества данных.

- содержание форм проверяется на валидность

- запрашиваются только данные, влияющие на возможность выполнения заказа

- данные сохраняются при перезагрузке страницы

- капчу можно разгадать с первого раза

- дополнительные поля вынесены в форму, предлагаемую к заполнению после регистрации

- автоматическая авторизация сразу после регистрации

- для некоторых прогрессивных сфер – авторизация через соц. сети

14.5 Проверка текстов на юзабилити

Текст на странице должен быть не только полезным, но и понятно оформленным, иначе его не станут читать.

- связки «заголовок + абзац»

- выделение смысловых акцентов через списки, цитаты, заголовки, картинки

- отступы и верстка по сетке

- функциональные элементы для решения задач

- ссылки внутри текста оформлены заметно

14.6 Проверка перелинковки на полезность с т.з. пользователя

Все ссылки должны быть для людей. SEO встраивается в эту систему, а не наоборот. Нет смысла показывать на странице тура в Турцию ссылку на визы в Карачаево-Черкессию для белорусов. Необходим таргетинг.

- используются ли механизмы таргетинга при простановке ссылок

- эффективны ли эти механизмы, какова конверсия внутренних переходов

- проверка отсутствия т.н. seo-ссылок внутренней перелинковки в подвалах, в спец. разделах, в тексте "аля википедия".

14.7 Анализ конверсии входных страниц и сценариев поведения

Изучение конверсии входных страниц и путей следования пользователей по сайту позволяет сделать полезные выводы о поведенческих факторах.

- смотрим конверсию по разным запросам, изучаем отличия аудитории

- ставим эксперименты, проводим А/В тестирование

- изучаем через метрику видео-записи действий пользователей

- составляем логические цепочки на основе правой колонки wordstat и здравого смысла: какая информация необходима посетителю для свершения покупки

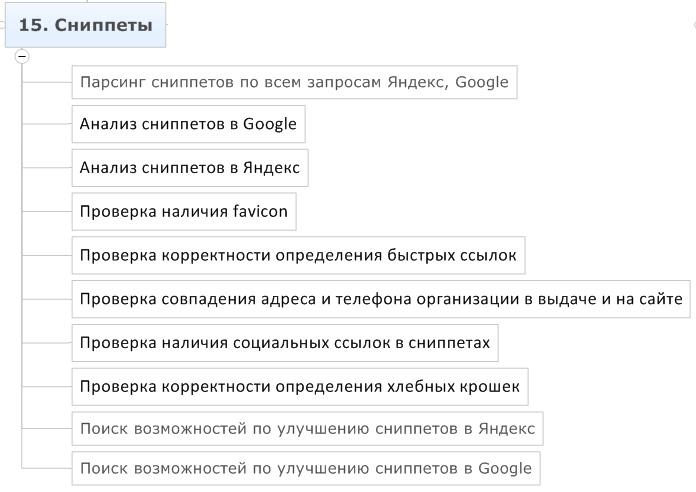

Часть #15 - Сниппеты

15.1 Парсинг сниппетов по всем запросам Яндекс, Google

Сниппеты оказывают существенное влияние на конверсию сайтов в выдаче. Это подтверждено исследованиями, проводимыми компанией Яндекс.

- по всем запросам спарсить сниппеты Яндекса и Google (A-Parser)

15.2 Анализ сниппетов в Google

Необходимо выделить и изучить, что каждая часть сниппета формируется корректно:

- ЧПУ URL

- отзывы по микроформату hReview

- заголовок (TITLE, DMOZ, анкор ссылки, текст страницы)

- указание авторства контента по микроформату hCard

- содержимое сайтов по микроформатам hProduct и GoodRelations

- мероприятия по микроформату hCalendar

- адрес по микроформату hCard

- хлебные крошки по микроформату Breadcrumb

- описание (текст страницы, description, описание в каталоге DMOZ)

Необходимо зафиксировать по каждому пункту, корректно ли формируется сниппет и существуют ли возможности к улучшению.

15.3 Анализ сниппетов в Яндекс

Необходимо выделить и изучить, что каждая часть сниппета формируется корректно:

- ЧПУ URL

- регистр букв в домене

- иконка (файл favicon.ico)

- заголовок сниппета (title, h1-h6, strong, b, ul, li, Я.каталог, DMOZ, Description)

- быстрые ссылки (структура, url, переходы по ссылкам)

- содержимое сайтов (микроразметка hCard, hRecipe, hReview, hProduct)

- регион (я.адреса, я.каталог)

- адрес (я.адреса)

- социальные ссылки (связанные аккаунты в соц. сетях)

- хлебные крошки (хлебные крошки, ЧПУ)

- описание (текст страницы, description, яндекс.каталог, анкор-лист)

- ссылки в описании

Необходимо зафиксировать по каждому пункту, корректно ли формируется сниппет и существуют ли возможности к улучшению.

15.4 Изучение областей, откуда берется описание

Для того, чтобы влиять на содержание описания, необходимо понять, откуда оно берется и по какому алгоритму. Для этого нужно собрать информацию по всем источникам данных, используемых поисковыми системами при формировании сниппетов.

- Парсинг Description (A-Parser, СайтРепорт)

- Парсинг Я.каталог, DMOZ (можно вручную)

- Сбор анкоров (ранее собраны через Я.вебмастер, ahrefs, выгрузки бирж)

- Парсинг B, STRONG, LI, H1, H2, H3, H4, H5, H6, TITLE (модуль Page Auditor в СайтРепорт)

- Парсинг текста страниц (A-Parser может собрать сохраненные текстовые копии)

- Сравнение данных о сниппетах с данными об источниках

Часть #16 - Ссылочная масса

16.1 Получение ссылок из различных источников

Необходимо собрать ссылки со всех источников

- яндекс.вебмастерс

- ahrefs, majesticseo, solomono

- выгрузка с бирж и агрегаторов

16.2 Получение данных о ссылках

Для анализа ссылок необходимо получить данные о всей ссылочной массе.

- URL

- тИЦ

- PR

- кол-во исходящих ссылок со страницы

- возраст

- Як.

- ДМОЗ

- дата индексации

- текст ссылки

- цена

- количество входящих ссылок на сайт

- количество исходящих ссылок с сайта

- трафик сайта

- страниц сайта в индексе Яндекс

- страниц сайта в индексе Google

16.3 Анализ динамики изменения ссылочной массы

Необходимо изучить динамику изменений ссылочной массы

- MajesticSEO

- Ahrefs

16.4 Проверка индексации страниц-доноров

Далеко не все размещенные ссылки попадают в индекс поисковых систем. Некоторые ссылки могут стоять несколько лет, прежде чем SEO специалист узнает, что их до сих пор нет в индексе.

- после покупки – проверка индексации страниц (руками кэш в яндексе, плагин wink)

- при покупке – изучение индексации похожих страниц сайта, размещенных ранее

16.5 Сбор анкор-листа

Тексты ссылок участвуют в ссылочном ранжировании. Необходимо собрать всю доступную информацию об анкорах.

- внутренний анкорлист – СайтРепорт (Проект -˃ Отчет по загрузке -˃ Коллектор анкоров)

- внешний анкорлист – Ahrefs, Solomono, Majesticseo

- проанализировать по матрице по популярной странице каждого типа

16.6 Анализ ссылочной массы на атаки конкурентов

Иногда приходится сталкиваться с недобросовестными конкурентами.

- поиск ссылочных взрывов (MajesticSEO, Ahrefs)

- поиск спамных ссылок (excel по выгрузкам)

- поиск спамных анкоров (excel по выгрузкам)

- поиск ссылок с бирж, которых нет на аккаунтах компании

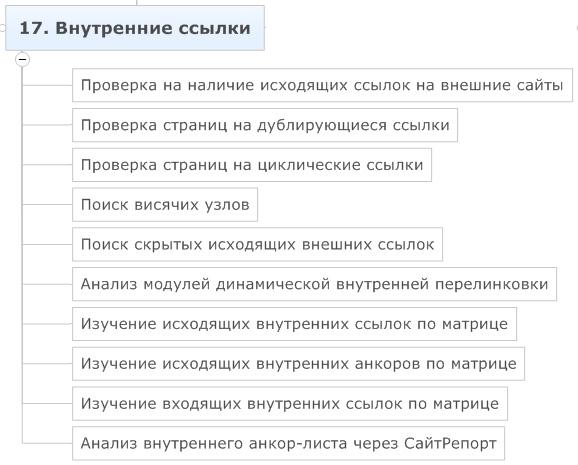

Часть #17 - Внутренние ссылки

17.1 Изучение списка исходящих ссылок на внешние сайты

Статический вес распределяется между всеми ссылками сайта, если ссылок на другие ресурсы существенное количество – продвигаемые страницы сайта могут недополучать веса.

- Просмотр списка доменов, на которые стоят ссылки

- Просмотр списка ссылок на внешние ресурсы: СайтРепорт, RDSBar

17.2 Проверка страниц на дублирование ссылок

Некоторые ссылки могут дублироваться. Это мешает специалисту контролировать передачу статического веса и анкорное ранжирование. Необходимо найти такие ссылки и решить, что с ними делать.

- Поиск доноров среди внутренних ссылок, которые несколько раз ссылаются на акцептор

17.3 Проверка страниц на циклические ссылки

Циклические ссылки – это ссылки, которые ссылаются сами на себя.

- Поиск циклических ссылок по сайту (СайтРепорт)

17.4 Анализ модулей динамической внутренней перелинковки

Модуль динамической перелинковки может быть полезен для SEO, если его правильно использовать.

- Проверка на индексацию таких ссылок

- Проверка наличия таргенга и его эффективность

- Проверка анкоров на SEO нужды

17.5 Изучение исходящих внутренних анкоров и внутренних ссылок по матрице

Изучение исходящих внутренних ссылок и их анкоров позволит понять, какие ссылки лишние, как используются анкоры

- Определяем что закрывать в SEOHide

- Определяем что удалять

- Определяем где поменять анкор

17.6 Изучение входящих внутренних ссылок по матрицее

Необходимо изучить по входным страницам, откуда на них стоят ссылки.

- Анализ внутренних доноров (СайтРепорт, Page-Weight)

17.7 Анализ внутреннего анкор-листа через СайтРепорт

Важно посмотреть на ссылки как с позиции донора, так и с позиции акцептора.

- Изучение внутреннего листа (коллектор анкоров в СайтРепорт)

- Определяем, какие анкоры добавить, какие убрать, в соответствии с семантикой по критериям разнообразия, наличия безанкорных ссылок, переспама.

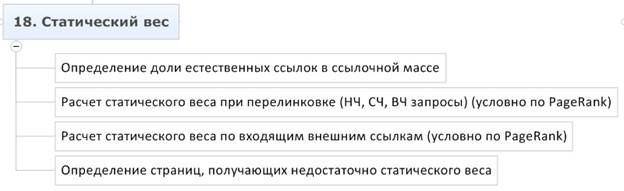

Часть #18 - Статический вес

18.1 Определение страниц, получающих недостаточно статического веса

Часть важных страниц может недополучать статический вес, вместо этого наибольший вес может переходить не продвигаемым и техническим страницам.

- Сортировка страниц по PageRank в СайтРепорте или другом сервисе

- Сравнение полученного списка со списком входных страниц;

18.2 Расчет статического веса при перелинковке (НЧ, СЧ, ВЧ запросы) (условно по PageRank)

Статический вес имеет большое значение, рассчитав распределение статического веса и направив его на продвигаемые страницы можно существенно повысить трафик из поисковых систем.

- Изучить текущее распределение статического веса между страницами сайта (Page-Weight, СайтРепорт)

- Сделать расчеты распределения стат. веса и выбрать оптимальную схему (Excel)

18.3 Расчет статического веса по входящим внешним ссылкам (условно по PageRank)

Статический вес имеет большое значение, рассчитав распределение статического веса и направив его на продвигаемые страницы можно существенно повысить трафик из поисковых систем.

- Оцениваем ссылки по тулбарному PageRank

- Добавляем в схему распределения PageRank данные по внешним ссылкам;

Данные расчеты позволяют примерно определить, когда выгоднее поставить ссылки на раздел, а когда на карточки товаров.

Часть #19 - Анкоры

19.1 Определение доли некоммерческих анкоров в анкор-листе

При продвижении часть ссылок должны иметь некоммерческий анкор.

- Анализ анкорлиста (тексты всех внешних и внутренних ссылок)

- Расчет доли некоммерческих анкоров

19.2 Проверка анкор-листа на релевантность запросам

Формула BM25 позволяет определить одну из границ релевантности анкорлиста.

- Рассчитать BM25 анкор-листа по запросам (Excel)

19.3 Проверка анкор-листа на полноту охвата семантики (внутр. + внешн. ссылки)

Перед тем, как ставить новые ссылки, необходимо собрать статистику по текущим анкорам.

- Подготовка списка запросов

- Наличие всех запросов в анкор-листе (проставленные и проиндексированные ссылки)

- Наличие разбавок ко всем СЧ и ВЧ запросам в анкор-листе

19.4 Анализ покупных ссылок на наличие информационных анкоров

При ранжировании информационных запросов коммерческие SEO ссылки не передают вес. Необходимо проверить список ссылок на наличие таких.

- Проверка, что информационные запросы покупными ссылками не продвигаются

19.5 Проверка анкор-листа на спамность (внутр. + внешн. ссылки)

Ещё одна грань релевантности анкорлиста – переспам. SEO специалист должен лавировать между релевантностью по BM25 и переспамом анкор-листа.

- Спамность считается по кол-ву повтора анкора

- Спамность считается по наличию анкоров с повторами слов внутри одного

19.6 Проверка анкор-листа на наличие уникальных биграмм

Некоторые SEO специалисты в качестве анкоров ссылок по-старинке используют редкие слова. Это может расцениваться поисковой системой как спам.

- Запросом к ПС определяем, нет ли несуществующих комбинаций слов

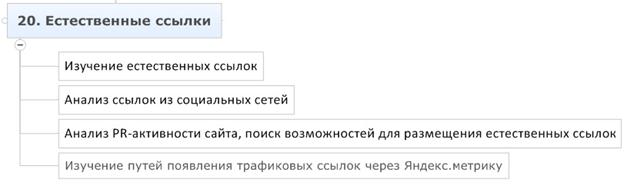

Часть #20 - Естественные ссылки

20.1 Определение доли естественных (живых) ссылок в ссылочной массе

Естественные ссылки играют важную роль в ранжировании сайтов.

- получаем список ссылок из Яндекс.Метрики

- считаем кол-во ссылок по которым были переходы ко всему кол-ву

20.2 Изучение естественных ссылок

Если сайт получил естественные ссылки в результате каких-то действий, полезно изучить эти действия и создать сценарии наращивания естественных ссылок.

- изучить природу возникновения естественных ссылок, их количество и передаваемый трафик

20.3 Анализ ссылок из социальных сетей

Часть ссылок может быть размещено в социальных сетях.

- изучить инфоповоды

- изучить площадки, разместившие ссылки

- составить список решений и инструментов, которые можно использовать для увеличения ссылок из соц. сетей

20.4 Анализ PR-активности сайта, поиск возможностей для размещения естественных ссылок

Взаимодействие SEO с PR позволяет получать ссылки с самых крупных и интересных ресурсов, где купить ссылку невозможно.

- поиск PR площадок

- поиск возможностей использовать PR площадки для простановки ссылок

20.5 Поиск и изучение отзывов о компании

Наличие отрицательных отзывов в видимой части индекса снижает конверсию вашего сайта, приводит к снижению продаж и как следствие понижению поведенческих факторов.

- наличие отрицательных отзывов в видимой части выдачи крайне негативно сказывается на конверсии, в т.ч. на поведенческих факторах

- важно знать площадки, где в вашей тематике можно оставить отзывы, в т.ч. универсальные площадки

- необходимо стимулировать клиентов оставлять отзывы

- отсутствие отзывов тоже негативно сказывается на конверсии

20.6 Анализ трафика с сайтов через Яндекс.Метрику

Анализируя источники трафика можно найти много интересных площадок для PR и SEO.

- откуда идет трафик

- характер появления ссылок, которые дают трафик

- содержание страниц, откуда идет трафик

- поиск сценариев для привлечения подобных ссылок

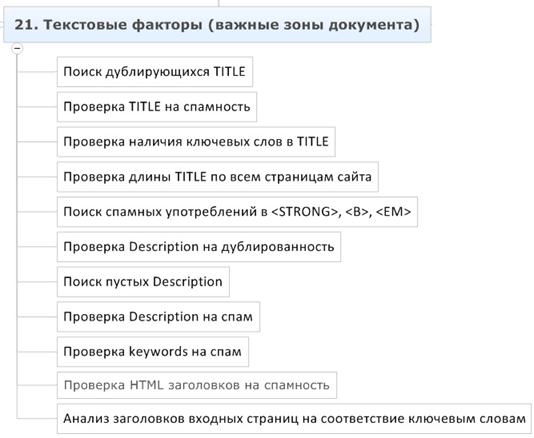

Часть #21 - Текстовые факторы (важные зоны документа)

21.1 Поиск дублирующихся TITLE

Существует правило – 1 запрос нельзя продвигать на 2 страницы. Дублирование TITLE нарушает это правило, поскольку размывает релевантность продвигаемой страницы.

- необходимо найти на сайте все дубликаты TITLE (сервисы СайтРепорт, Google.WebMaster)

21.2 Проверка TITLE на спамность

На некоторых страницах SEO специалист могут перестараться с употреблением ключевых слов в TITLE. При генерации, кстати, TITLE так же могут быть спамными.

- поиск TITLE, где несколько раз повторяются ключевые слова

- ручной отсмотр списка всех TITLE сайта (такой отчет есть в СайтРепорт)

21.3 Проверка наличия ключевых слов в TITLE

Необходимо выполнить проверку наличия ключевых слов в TITLE.

- построить таблицу проверки наличия слов в TITLE (excel)

21.4 Проверка длины TITLE по всем страницам сайта

TITLE дает бонус при ранжировании словам, находящимся в видимой части заголовка, если написать слишком длинный TITLE, ключевые слова, употребляемые далеко от начала при ранжировании будут расцениваться как обычный текст.

- построить таблицу проверки наличия слов в TITLE (excel)

21.5 Поиск спамных употреблений в <STRONG>, <B>, <EM>

Наследие прошлого – оптимизация ключевых слов с использованием тегов <strong> и др., иногда встречаются на сайтах заказчиков. Явный спам с использованием этих тегов может представлять угрозу для ранжирования.

- отчет по тегам в СайтРепорте

21.6 Проверка Description на дублированность

Содержимое тегов Description должно быть уникальным.

- отчет по тегам (СайтРепорт)

21.7 Проверка Description на спам

Рекомендуется проверить содержимое тегов Description на спамность.

- ручной анализ выгрузки списка всех Description (СайтРепорт)

21.8 Проверка HTML заголовков на спамность

Содержимое тегов H1 – H6 оказывает большее влияние на ранжирование, чем обычный текст. Для этого необходимо корректно использовать их и не спамить.

- выгрузки по странично в отчете по тегам списка H1, H2, H3, H4, H5, H6 (СайтРепорт)

- парсинг всех страниц сайта и выгрузка содержания тегов (A-Parser)

21.9 Анализ заголовков входных страниц на соответствие ключевым словам

Необходимо проверить, что содержание заголовков H1, H2, H3, H4, H5, H6 соответствует продвигаемым запросам.

- необходимо свести таблицу семантики и выгрузку по заголовкам (Excel)

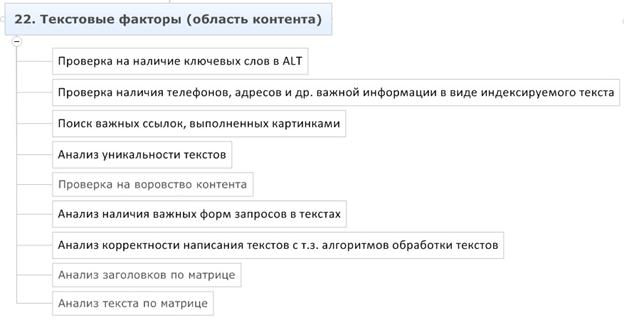

Часть #22 - Текстовые факторы (область контента)

22.1 Проверка на наличие ключевых слов в ALT

Содержимое атрибута ALT влияет на ранжирование изображения.

- сводка всех ALT на сайте (парсинг + excel)

22.2 Проверка наличия телефонов, адресов и др. важной информации в виде индексируемого текста

Контактная информация должна быть представлена индексируемым текстом в HTML коде.

- проверка вручную по выборочным страницам

22.3 Поиск важных ссылок, выполненных картинками

Поскольку текст ссылки участвует в ранжировании, часть важных ссылок обязательно должны быть оформлены в виде текстовых ссылок.

- проверка ссылок на содержание тега <IMG> (сервис СайтРепорт)

22.4 Анализ уникальности текстов

Необходимо убедиться в отсутствии дублей контента внутри сайта.

- сравнение контента внутри сайта (сервис СайтРепорт)

22.5 Проверка на воровство контента

Необходимо убедиться, что контент не украден.

- сравнение текстов выборочных страниц всей матрицы с индексо

- проверка с помощью сервисов (https://seobudget.ru/tools/unique/)

- используется ли сервис сообщения об уникальном контенте в Яндекс.Вебмастер

22.6 Анализ наличия важных форм запросов в текстах

Важно убедиться, что тексты содержат точные формы наиболее частых запросов.

- проверка наличия точной формы запроса в тексте

22.7 Анализ корректности написания текстов с т.з. алгоритмов обработки текстов

- оценка расстояний между словами

- употребление запросов в рамках одних пассажей

22.8 Анализ заголовков по матрице

- Содержание прямых вхождений всех популярных форм запросов

- Достаточное кол-во заголовков

- Использование заголовков по прямому назначению

22.9 Анализ текста по матрице

- Наличие

- Объем

- Содержание

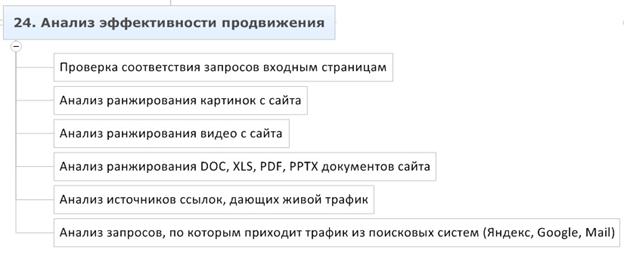

Часть #23 - Анализ эффективности продвижения

23.1 Проверка соответствия запросов входным страницам

При продвижении существует риск ситуации, когда поисковая система сменяет продвигаемые страницы. Необходимо постоянно держать на контроле соответствие запросов продвигаемым страницам.

- сбор данных о продвигаемых страницах (a-parser)

- сравнение соответствия продвигаемой страницы в выдаче семантике

- анализ делается на основе отчета о продвижении

23.2 Анализ ранжирования картинок с сайта

Сайты фотобанков, галереи и многие другие проекты получают значительное количество трафика с поиска картинок.

- проверка данных о позициях (a-parser)

23.3 Анализ ранжирования видео с сайта

Для некоторых сайтов трафик по видео-контенту имеет высокий приоритет.

23.4 Анализ ранжирования DOC, XLS, PDF, PPTX документов сайта

Для некоторых сайтов может быть важен трафик по документам.

- стандартная проверка по специфическим запросам (A-parser)

23.5 Анализ запросов, по которым приходит трафик из поисковых систем (Яндекс, Google, Mail)

Анализ запросов, по которым приходит трафик, может показать как новые анкоры для перелинковки, так и новые направления для развития контента сайта.

- изучение списка запросов через (я.метрика), включение запросов в семантику

- расширение семантического ядра на основании полученных данных

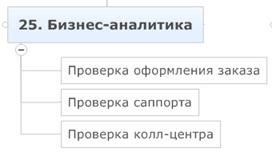

Часть #24 - Бизнес-аналитика

24.1 Проверка оформления заказа

Несмотря на усилия SEO специалистов, результат работы могут свести на нет ошибки системы оформления заказа. Автору приходилось сталкиваться с ситуациями, когда клиент сомневался в эффективности SEO, из-за того, что не смотря на рост трафика, заказов не прибавлялось.

- оформляем пару заказов и замеряем

- время реакции

- корректность обработки данных

- соответствие наличия товаров на сайте и на складе (заказываем редкий товар)

- соответствие срока доставки указанному на сайте

- возможность оплачивать редкой валютой

- возможность самовывоза, соответствующая данным на сайте

24.2 Проверка саппорта

Служба саппорта может долго реагировать на запрос, давать некорректную информацию.

- матерный злой запрос

- стандартный запрос

- замер времени ответа

- информативность

- готовность и способность решить проблему

- соответствие режима работы, указанному на сайте

24.3 Проверка колл-центра

В результате работы неэффективного call центра сайт может потерять позиции по поведенческим факторам. Клиент может потерять заказы.

- злой клиент

- звонок в обеденное время

- звонок за 5 минут до конца рабочего дня

- оформление заказа по телефон

- глупые вопросы

- сложные вопросы

- обещание перезвонить

24.4 Сравнение ценовых предложений

Возросший трафик не повысит продаж, если при формировании ценовых предложений заказчик не удерживает во внимании колебания цен на рынке.

- изучить топ-10 по наиболее популярным товарам и сравнить ценовые и сервисные предложения с конкурентами

24.5 Осведомление клиента о возможном увеличении нагрузки на колл-центр

Обязанность SEO-специалиста – проинформировать клиента о том, что возможен резкий рост трафика и в таком случае нагрузка на call центр возрастет. Автору приходилось сталкиваться с ситуацией, когда клиент вынужден был остановить эффективное SEO из-за того, что не успевал расширять call центр.

Часть #25 - Сводная таблица

25.1 Таблица приоритетов: критические, важные и незначительные ошибки

25.2 Формат: фактор, статус, что делать, приоритет

Приложение

Список программ и сервисов, используемых в процессе аудита:

- Поиск с использованием спец. операторов Yahoo – https://www.yahoo.ru/

- Поиск с использованием спец. операторов Яндекс – https://www.yandex.ru/

- Поиск с использованием спец. операторов Google – https://www.google.ru/

- Построение таблиц в Excel

- Сервис Яндекс.Метрика – https://metrika.yandex.ru/

- Сервис Яндекс.Вебмастер - https://webmaster.yandex.ru/

- Сервис Google.Analytics - https://analytics.google.com/

- Сервис Webmasters.Google - https://webmaster.google.com/

- Сервис SEORate (анализ видимости) - https://www.seorate.ru/

- Сервис MegaIndex (комплекс инструментов аналитики) – https://www.megaindex.ru/

- Сервис wordstat.yandex.ru (анализ спроса) – https://wordstat.yandex.ru/

- Прогрмма Page-Weight (анализ сайта) – https://www.page-weight.ru/

- Программа Xenu (анализ сайта) - https://home.snafu.de/tilman/xenulink.html

- Сервис СайтРепорт (SEO анализ сайта) – https://сайтрепорт.рф/

- Сервис LoadImpact (проверка нагрузоустойчивости) - https://www.loadimpact.com/

- Сервис Awstats (анализ логов) - https://awstats.sourceforge.net/

- WebAlizer (анализ логов) - https://www.webalizer.org/

- Плагин PageOptimizer (проверка скорости загрузки) - https://chrome.google.com/webstore/search-apps/pagespeed

- Сервис PingDomTools (проверка скорости загрузки) - https://tools.pingdom.com/

- Программа A-Parser (универсальный парсер) – https://a-parser.com/

- Antigate (распознавание капчи)– https://antigate.com/

- Сервис AWM Proxy (прокси) – https://awmproxy.com/

- Сервис Alexa (веб аналитика) – https://www.alexa.com/

- Сервис валидации robots.txt от Яндекс – https://webmaster.yandex.ru/robots.xml

- Сервис валидации sitemap.xml от Яндекс – https://webmaster.yandex.ru/sitemaptest.xml

- Проверка орфографии Яндекс – https://www.webmaster.yandex.ru/spellcheck.xml

- Валидация микроразметки Яндекс – https://webmaster.yandex.ru/microtest.xml

- Плагин RDS bar – https://www.recipdonor.com/bar

- Сервис Skvotte.ru (поиск доменов по данным whois) – https://www.skvotte.ru/

- Сервис 2ip.ru (поиск доменов по данным whois) – https://2ip.ru/domain-list-by-email/

- Сервис recipdonor (поиск доменов по данным whois) – https://recipdonor.com/infowhois

- Nic.ru (анализ whois) – https://nic.ru/whois/

- Сервис Solomono (анализ ссылок) – https://www.solomono.ru/

- Плагин wink’a (анализ ссылок) – https://addons.mozilla.org/ru/firefox/addon/webmaster-sape/

- SEOBudget (проверка уникальности текста) – https://seobudget.ru/tools/unique/

- SEOBudget (распознавание CMS) – https://seobudget.ru/tools/cms/

- SEOBudget (определение посещаемости сайта) – https://seobudget.ru/visitors/

- SEOBudget (оценка влияния ПФ по запросам) – https://seobudget.ru/tools/factors/

- Alexa (веб аналитика) – https://www.alexa.com/

- SEOLib (потенциал трафика по запросам) – https://www.seolib.ru/script/pop/

- SEOLib (анализ конкуренции по запросам) – https://www.seolib.ru/help/seoprice/

- SEOLib (анализ геозависимости запросов) – https://www.seolib.ru/script/geo/

- SEOLib (анализ позиций) – https://www.seolib.ru/analytics/

- Плагин WebDeveloper (анализ страниц) – https://addons.mozilla.org/ru/firefox/addon/web-developer/

- Плагин LiveHTTPHeaders (анализ серверных ответов) - https://addons.mozilla.org/ru/firefox/addon/live-http-headers/

- Яндекс.антиспам API – https://api.yandex.ru/cleanweb/

- Acunetix (проверка сайта на уязвимости безопасности) – https://www.acunetix.com/

- Чек-лист по XSS уязвимостям – https://www.owasp.org/index.php/XSS_Filter_Evasion_Cheat_Sheet

- WebArchive (история интернета) – https://web.archive.org/

- HTML валидатор – https://validator.w3.org/